- Home

- Hochschule

-

Studium

- Studienangebote

-

Beratung

- Studienorientierung

- Zentrale Studienberatung

- Studienfachberatung

- Psychosoziale Beratung

- Studienfinanzierungsberatung und Stipendien

- Schreibberatung

- Studieren mit beruflicher Qualifikation

- Studieren mit ausländischen Zeugnissen

- Studieren mit Handicap

- Studieren mit Familie

- Informationen für Schulen

- Auslandsaufenthalt

-

Bewerbung

- Auswahlgrenzen und Vergabeverfahren (NC)

- Bewerbungsportal

- Bewerbung Schritt für Schritt: Von der Bewerbung bis zur Einschreibung

- Bewerbung für ein höheres Fachsemester

- Bewerbung mit beruflicher Qualifikation

- Gasthörerschaft und Zweithörerschaft

- Kontakt Studierendenservice

- Losverfahren

- Promotion

- Sonderanträge

- Studiengang wählen

- Wer kann an der HSBI studieren?

- Studienstart

-

Studium organisieren

- Studierendenservice

- Abschlussunterlagen

- Anerkennung von Leistungen

- Anträge einreichen

- Beurlaubung

- CampusCard

- Einreichung schriftliche Arbeiten

- Exmatrikulation

- IT-Services

- Online-Serviceportale (LSF/CAT)

- Prüfungsangelegenheiten: Ordnungen, Modulhandbücher

- Rücktritt von einer Modulprüfung

- Rückmeldung

- Semesterbeitrag

- Semesterticket (Studi-Deutschlandticket)

- Semester- und Vorlesungszeiten

- Studienbezogene Auslandserfahrung

- Studiengebühren

- Vorlesungsverzeichnis

- Rund ums Studium

- Fachbereiche

- Forschung

- Transfer

- Weiterbildung

- Internationales

- Karriere an der HSBI

Der KI-Rechtsberater

Projektübersicht

| Anzahl Studierende | 1 |

| Art | Studienprojekt (interdisziplinär, fachbereichsübergreifend; enge Anbindung an geförderte Projekte) |

| Projektverantwortung | Prof. Dr. W. Schenck, Prof. Dr. D. Hötte, N. Migenda, M.Eng., D. Pelkmann, B.Eng. |

| Projektkontext | Das Projekt findet in enger Zusammenarbeit mit dem Center for Applied Data Science (CfADS) Gütersloh und dem Fachbereich Wirtschaft und Gesundheit (Arbeitsgruppe „Applied Legal Tech“) statt. |

Rechtssysteme sind eine unverzichtbare Säule im deutschen Rechtssystem. Es stellt sich die Frage, wie ein juristischer Laie Informationen aus der überwältigen Anzahl an Gerichtsdokumenten gewinnen soll. Um juristische Informationen effizient zu extrahieren, ist ein kollaboratives System notwendig. Traditionell bedeutete dies, einen Anwalt oder Fachspezialisten zu konsultieren, was weder kostengünstig noch schnell ist. Mit dem Aufkommen groß angelegter Sprachmodelle und durch deren Unterstützung bei der Beantwortung von komplexen Fachfragen ergeben sich neue Möglichkeiten zur Unterstützung juristischer Laien. Mit der fortschreitenden Digitalisierung des Rechtssystems werden juristische Dokumente zunehmend digital abgespeichert. Derzeitige juristische Systeme zur Informationsbeschaffung, Datenbanken und kommerzielle Suchmaschinen speichern und verarbeiten große Mengen an juristischen Dokumenten. Leider ist es entweder sehr zeitaufwändig oder unmöglich, eine bestimmte Passage oder Antwort auf eine gestellte juristische Frage aus einem Dokumentenkorpus zu extrahieren, da die bestehenden Ansätze keine Möglichkeiten für die kontextbasierte Suche in deutschen Gerichtsdokumenten bieten. Daher ist es notwendig, ein System für den deutschen Rechtsraum zu entwickeln, das eine präzise Antwort auf eine gestellte Frage in einem großen juristischen Korpus liefert und einen kollaborativen und transparenten Zugang zu juristischen Informationen ermöglicht. Anschließend kann die Kombination der Suchfunktion mit einem Chatbot (einem textbasierten Dialogsystem) realisiert werden.

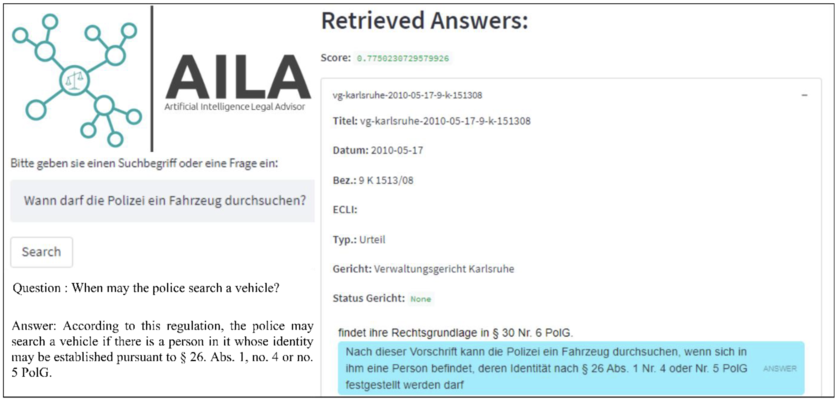

Das hier beschriebene Projekt ist der direkte Nachfolger des gleichnamigen Data-Science- Forschungsmasterprojekts „Der KI-Rechtsberater“. Im vorhergegangenen Projekt konnte bereits ein funktionierender Workflow zur kontextbasierten Suche entwickelt und implementiert werden. Dies ermöglicht einerseits einen reibungslosen Projektstart und bietet andererseits eine vielversprechende Ausgangssituation zur Fertigstellung eines höchst anwendungsrelevanten Projekts. Im untenstehenden Bild ist die Funktionalität präsentiert. Der Benutzer bekommt auf eine Frage eine passgenaue Antwort mit zugehörigem Paragrafen aus dem relevanten Originaldokument.

Entwicklung und Validierung einer KI-gestützten Suchmaschine (KI-Rechtsberater) für umfassende juristische Datenbestände wie beispielsweise Urteile oder Gesetzestexte. Hierfür ist die direkte Anbindung von Gerichtsdaten mittels „Web Scraper“ an die Daten-Pipeline zu implementieren. Mit der sich stetig ändernden Gerichtslage, ist ein semi-supervised ML Algorithmus zu identifizieren und zu implementieren, zum kontinuierlichen Nachtrainieren von Gerichtsdokumenten. In diesem Zusammenhang ist auch ein neues NoSQL-Datenbanksystem aufzusetzen und in die Daten-Pipeline zu integrieren. Der Fokus liegt auf Graphdatenbanken mit denen die Zusammenhänge auch visuell dargestellt werden können. Die neue Suchmaschine ist funktional und nutzerseitig in Studien zu validieren. Dies findet zunächst in internen Tests statt und die Resultate sind zur Verbesserung der Funktionalität umzusetzen. Anschließend ist ein ML-basierter Algorithmus für einen Chatbot zu implementieren. Abschließend wird der KI-Rechtsberater „Live-geschaltet“ und die Funktionalität wird in einer echten Umgebung auf die Probe gestellt.

Bezug zum Thema Data Science

Das Projekt hat in jeder Hinsicht einen sehr engen Bezug zum Thema Data Science: Von der Datensammlung über die Datenintegration bis hin zur Datenanalyse mit aktuellen ML- und NLP-Verfahren.

Verfügbare Ressourcen

- Der Data-Analytics-Cluster des CfADS steht über die Projektlaufzeit zur Verfügung.

- Es existieren aufbereitete und annotierte Gerichtsdatensätze.

- Auf deutsche Gerichtsurteile nachtrainierte ML-Modelle sind vorhanden.

- Aktive Unterstützung beim Erstellen von wissenschaftlichen Arbeiten, die auf (internationalen) Konferenzen präsentiert werden.

- Die Betreuung durch das Team der Ansprechpartner ist über die Projektlaufzeit gewährleistet.

Projektplan

Erstes Semester: Im ersten Semester liegt der Fokus auf der Einarbeitung in die vorhandene Infrastruktur (Data-Analytics-Cluster des CfADS) und die Schnittstelle zwischen dem Rechtswesen und der künstlichen Intelligenz. In diesem Zusammenhang ist besonders die Einarbeitung in die Themenbereiche ML, NLP und Data Engineering vorgesehen. Außerdem ist es notwendig, sich mit der vorhandenen Datengrundlage vertraut zu machen. Die aktuelle Suchmaschine bezieht die Daten von einem Drittanbieter. Um unabhängig von diesem zu werden, ist außerdem ein „Web Scraper“ zu implementieren, mit dem die Daten direkt vom jeweiligen Gericht geladen werden können. Die Prüfungsleistung ist das Erstellen eines Forschungsexposés auf Englisch und ein dazugehöriges Kolloquium.

Zweites Semester: Die aktuelle Suchmaschine wird einmalig auf dem vorhandenen Datenkorpus trainiert. Natürlich ändern sich die Gesetze stetig, sodass ein kontinuierliches Nachtrainieren notwendig ist, damit Fragen passgenau beantwortet werden können. Hierfür ist ein dementsprechendes Modell (bspw. semi-supervised) zu implementieren und funktional zu validieren. Zudem ist die aktuelle Datenbankstruktur zu überdenken. So bieten sich bspw. Graphdatenbanken an, um stark vernetzte Informationen darzustellen und abzuspeichern. Die Prüfungsleistung ist das Schreiben eines Short-Papers und dem Einreichen auf einer (internationalen) Konferenz. Idealerweise wird das Paper auf der Konferenz präsentiert.

Drittes Semester: Durch die Ergänzungen der Suchmaschine, die in den ersten zwei Semestern implementiert wurden, soll die Suchmaschine in diesem Semester fertiggestellt werden und in die Anwendung gehen. Hierbei liegt der Fokus auf der nutzerseitigen und funktionalen Validierung der Suchmaschine. Hierfür sind Studien durchzuführen, mit denen durch das User-Feedback die Suchmaschine optimiert werden kann. Eine Möglichkeit besteht darin, die Suchmaschine, um einen Feedback-Button zu erweitern, so dass Anwenderfeedback automatisch zum Nachtrainieren des Modells (siehe zweites Semester) verwendet werden kann. Die Prüfungsleistung ist, aufbauend auf dem Short-Paper des zweiten Semesters ein Full-Paper zu schreiben. Idealerweise wird das Paper auf einer Konferenz präsentiert.

Viertes Semester: In der Masterarbeit soll die Suchmaschine „Live gehen“. Dies bedeutet, sich aus der sicheren internen Umgebung heraus zu begeben und die Funktionalität in der realen Welt auf die Probe zu stellen. Dies birgt viele unvorhersehbare Herausforderungen, die für den Praxiseinsatz aber höchst relevant sind. Zudem besteht die Möglichkeit, die Funktionalität der Suchmaschine zu erweitern. Einerseits ist das Erstellen eines Chatbots erstrebenswert. Zudem kann die Datenbasis und die Suchmaschine um verwandte Dokumente (bspw. von Behörden) erweitert werden.

Eignungskriterien

Zwingend:

- Bachelorabschluss in einer einschlägigen Fachrichtung (Informatik, Kognitionswissenschaft, Jura verbunden mit umfassenden Informatikkenntnissen, o.ä.)

- Umfassende Programmierkenntnisse in mindestens einer objektorientierten Programmiersprache

- Fließendes Englisch in Wort und Schrift

- Programmierkenntnisse in Python

- Grundkenntnisse in NoSQL-Datenbanken

Erwerbbare Kompetenzen

Der/die Studierende ist nach Abschluss des Projekts in der Lage,

- einen Big-Data-Workflow für juristische Anwendungen aufzusetzen (Datenerfassung, - speicherung und -aufbereitung),

- die für die Verarbeitung von Texten relevanten ML- und NLP-Verfahren zielgerichtet anzuwenden und anwendungsbezogen anzupassen und ggf. weiterzuentwickeln,

- die theoretischen Anforderungen von ML-Verfahren mit den Erfordernissen der Praxis in Einklang zu bringen,

- textbasierte Dialogsysteme anzuwenden,

- die eigenen Forschungsergebnisse vor einem Fachpublikum zu präsentieren

- und wissenschaftliche Texte zu verfassen.